标签: voice-recognition

是否有 API(或任何 hack)可以访问 Mac OS X Mavericks 中的增强听写功能?

我正在尝试找到一种简单的方法将音频文件转录为文本(CMU Sphinx、Julius 等对于不了解语音识别、配置语言模型、声学模型等的人来说很难)。

我想知道是否有办法将我的音频文件传输到 Mac OS 10.9 Mavericks 的“增强听写”功能中,该功能允许本地离线语音听写。

当我将耳机插孔的跳线插入线路时,我以为我很聪明,但不幸的是,当你开始听写时,它会将所有其他音频播放静音(任何有关如何禁用此静音的建议都会从我这里得到正确的答案) )。

macos speech-recognition speech-to-text voice-recognition osx-mavericks

推荐指数

解决办法

查看次数

ALSA lib pcm_hw.c:1667:(_snd_pcm_hw_open) 卡 arecord 的值无效:main:722:音频打开错误:没有那个文件或目录

我正在研究语音识别。为此,我正在使用“alsa-utils”,但是当我尝试使用此脚本时

#!/bin/bash

echo “Recording… Press Ctrl+C to Stop.”

arecord -D plughw:1,0 -q -f cd -t wav | ffmpeg -loglevel panic -y -i – -ar 16000 -acodec flac file.flac > /dev/null 2>&1

echo “Processing…”

wget -q -U “Mozilla/5.0” –post-file file.flac –header “Content-Type: audio/x-flac; rate=16000” -O – “http://www.google.com/speech-api/v1/recognize?lang=en-us&client=chromium” | cut -d” -f12 >stt.txt

echo -n “You Said: ”

cat stt.txt

rm file.flac > /dev/null 2>&1

我收到这个错误

“Recording… Press Ctrl+C to Stop.”

ALSA lib pcm_hw.c:1667:(_snd_pcm_hw_open) Invalid value for card

arecord: main:722: audio open …推荐指数

解决办法

查看次数

为什么MFCC提取库返回不同的值?

我正在使用两个不同的库来提取MFCC功能:

- python_speech_features lib

- BOB lib

然而,两者的输出是不同的,甚至形状也不相同.这是正常的吗?还是有一个我缺少的参数?

我的代码的相关部分如下:

import bob.ap

import numpy as np

from scipy.io.wavfile import read

from sklearn import preprocessing

from python_speech_features import mfcc, delta, logfbank

def bob_extract_features(audio, rate):

#get MFCC

rate = 8000 # rate

win_length_ms = 30 # The window length of the cepstral analysis in milliseconds

win_shift_ms = 10 # The window shift of the cepstral analysis in milliseconds

n_filters = 26 # The number of filter bands

n_ceps = 13 # The number of cepstral …推荐指数

解决办法

查看次数

世博语音识别

我一直在尝试在我的 Expo 应用程序上实现语音识别,我尝试使用名为 的语音到文本库,react-native-voice但它不支持 Expo. 有谁知道我可以使用的任何其他图书馆。我读过一些关于使用 Google 的 api 的文章,但它对我来说太复杂了,我更喜欢一个可以支持 Expo 的更简单的替代方案。

speech-recognition speech-to-text voice-recognition react-native expo

推荐指数

解决办法

查看次数

是否可以通过编程方式使用 Chrome 实时字幕?

推荐指数

解决办法

查看次数

Galaxy Watch 4 提供语音识别功能吗?

我尝试使用 Android Studio 在我的 Galaxy Watch 4 上使用 Kotlin 语言进行语音识别,但该设备似乎无法使用该功能。

SpeechRecognizer.isRecognitionAvailable(this) 的值为 False。

我已授予许可:

<uses-permission android:name="android.permission.RECORD_AUDIO" />

我尝试添加这个:

<queries>

<intent>

<action android:name="android.speech.RecognitionService" />

</intent>

</queries>

但 SpeechRecognizer.isRecognitionAvailable(this) 的值仍然是 False。

在 Galaxy Watch 4 上是否可以通过编码使用语音识别?我读到,WearOS 3 无法通过编码进行语音识别。这是真的吗?

android voice-recognition kotlin wear-os samsung-galaxy-watch-4

推荐指数

解决办法

查看次数

如何使用RecognizerIntent构建BufferReceived()来捕获语音?

我正在使用RecognizerIntent.ACTION_RECOGNIZE_SPEECH ,,,我的问题是,我的问题是,我不知道如何创建将捕获用户输入的语音的缓冲区.我在堆栈溢出上读了很多,但我只是不明白我将如何将缓冲区和识别服务回调到我的代码中.以及我将如何回放保存到缓冲区的内容.

这是我的代码:

public class Voice extends Activity implements OnClickListener {

byte[] sig = new byte[500000] ;

int sigPos = 0 ;

ListView lv;

static final int check =0;

protected static final String TAG = null;

@Override

protected void onCreate(Bundle savedInstanceState) {

// TODO Auto-generated method stub

super.onCreate(savedInstanceState);

setContentView(R.layout.voice);

Intent intent = new Intent(RecognizerIntent.ACTION_RECOGNIZE_SPEECH);

intent.putExtra(RecognizerIntent.EXTRA_LANGUAGE_MODEL,

RecognizerIntent.LANGUAGE_MODEL_FREE_FORM);

intent.putExtra(RecognizerIntent.EXTRA_CALLING_PACKAGE,

"com.domain.app");

SpeechRecognizer recognizer = SpeechRecognizer

.createSpeechRecognizer(this.getApplicationContext());

RecognitionListener listener = new RecognitionListener() {

@Override

public void onResults(Bundle results) {

ArrayList<String> voiceResults = results

.getStringArrayList(SpeechRecognizer.RESULTS_RECOGNITION); …推荐指数

解决办法

查看次数

是否可以在Google Glass上安装Android语音识别功能(作为自定义服务)?

我们有一个演示Android应用程序(Android 4.0.3),它将语音识别作为服务运行,并且(连续地)在视图上记录识别结果.

我们的智能手机一切正常.

我们希望在Google Glass沉浸式应用程序中复制此方案,但是当我们尝试启动服务时,我们始终会收到此错误消息:

没有选定的语音识别服务

有一些已知的限制吗?或者有人想出如何解决这类问题?

提前致谢

这是活动的一些重要代码:

public class MainActivity extends Activity implements Observer {

...

@Override

protected void onStart() {

super.onStart();

//Toast.makeText(this, "Hi guys", Toast.LENGTH_LONG);

startService(new Intent(this, SilentVoiceRecognitionService.class));

}

...

}

这是服务的代码:

public class SilentVoiceRecognitionService extends Service {

protected AudioManager mAudioManager;

protected SpeechRecognizer mSpeechRecognizer;

protected Intent mSpeechRecognizerIntent;

protected final Messenger mServerMessenger = new Messenger(new IncomingHandler(this));

private Model model = Model.getInstance();

static final String TAG = "SilentRecognizer";

static final int MSG_RECOGNIZER_START_LISTENING = 1;

static final int MSG_RECOGNIZER_CANCEL = …android voice-recognition android-service google-glass google-gdk

推荐指数

解决办法

查看次数

在.Net中对音素的演讲

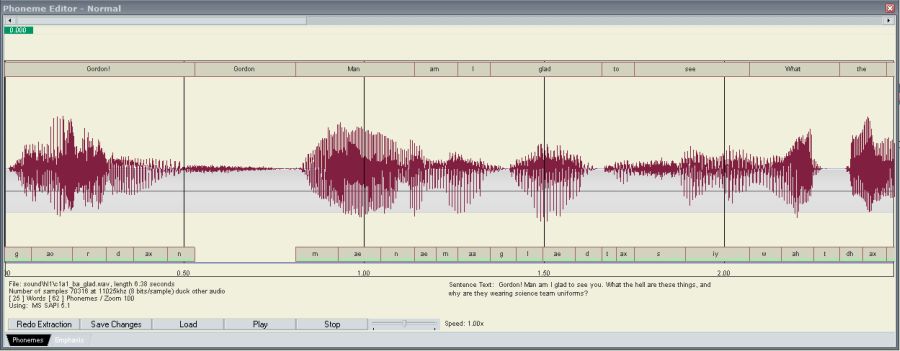

问题是我想用C#语言获取音频语音的音素.假设你有一个像"x.wav"这样的音频文件,上面写着"你好亲爱的Shamim".我想提取演讲的所有音素和他们的相对时间.如下图所示:

我使用了System.Speech库(两者recognition和synthesis命名空间),但我找不到我想要的东西.现在别搞错了!我不想要句子的语句"亲爱的Shamim",我想从未知的音频输入中提取音素和英语句子.我试过System.Speech.Recognition但它试图从音频文件中提取出来的话,而不是手机!正如你可能猜到的那样,30%的错误!;)

推荐指数

解决办法

查看次数

如何在Android设备中获取Google语音识别引擎

我有一个基于Android的Epson Moverio设备,但默认情况下没有语音识别引擎.我已经成功安装了语音搜索应用程序,因此,我能够在我正在开发的应用程序中使用谷歌语音识别.现在,问题是我得到的应用程序版本有点陈旧(我认为它来自2011年,因为那是语音搜索应用程序的最后一次更新).还有其他应用程序类似于我可以安装的语音搜索,并允许我使用最新的谷歌语音识别引擎吗?

推荐指数

解决办法

查看次数

标签 统计

android ×4

speech ×2

alsa ×1

c# ×1

expo ×1

google-gdk ×1

google-glass ×1

google-voice ×1

kotlin ×1

libalsa ×1

macos ×1

mfcc ×1

phoneme ×1

python ×1

react-native ×1

ubuntu ×1

voice ×1

wear-os ×1