逻辑回归 - 计算成本函数会返回错误的结果

No *_*ply 4 matlab machine-learning gradient-descent logistic-regression

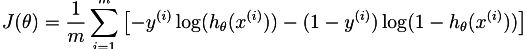

我刚刚开始在Coursera 上学习 Andrew Ng的机器学习课程.第三周的主题是逻辑回归,所以我试图实现以下成本函数.

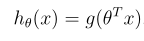

该假设定义为:

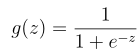

其中g是sigmoid函数:

这就是我的功能当前的样子:

function [J, grad] = costFunction(theta, X, y)

m = length(y); % number of training examples

S = 0;

J = 0;

for i=1:m

Yi = y(i);

Xi = X(i,:);

H = sigmoid(transpose(theta).*Xi);

S = S + ((-Yi)*log(H)-((1-Yi)*log(1-H)));

end

J = S/m;

end

给出以下值

X = [magic(3) ; magic(3)];

y = [1 0 1 0 1 0]';

[j g] = costFunction([0 1 0]', X, y)

j返回0.6931 2.6067 0.6931,即使结果应为j = 2.6067.我假设Xi有问题,但我看不出错误.

如果有人能指出我正确的方向,我将非常感激.

您应该将sigmoid函数应用于参数向量(theta)和输入向量(Xi在本例中为行向量)的点积.所以,你应该改变

H = sigmoid(transpose(theta).*Xi);

至

H = sigmoid(theta' * Xi'); % or sigmoid(Xi * theta)

当然,您需要确保将偏置输入1添加到输入(1到1行X).

接下来,考虑如何对整个操作进行矢量化,以便可以在没有任何循环的情况下编写它.这样会快得多.

| 归档时间: |

|

| 查看次数: |

783 次 |

| 最近记录: |